Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

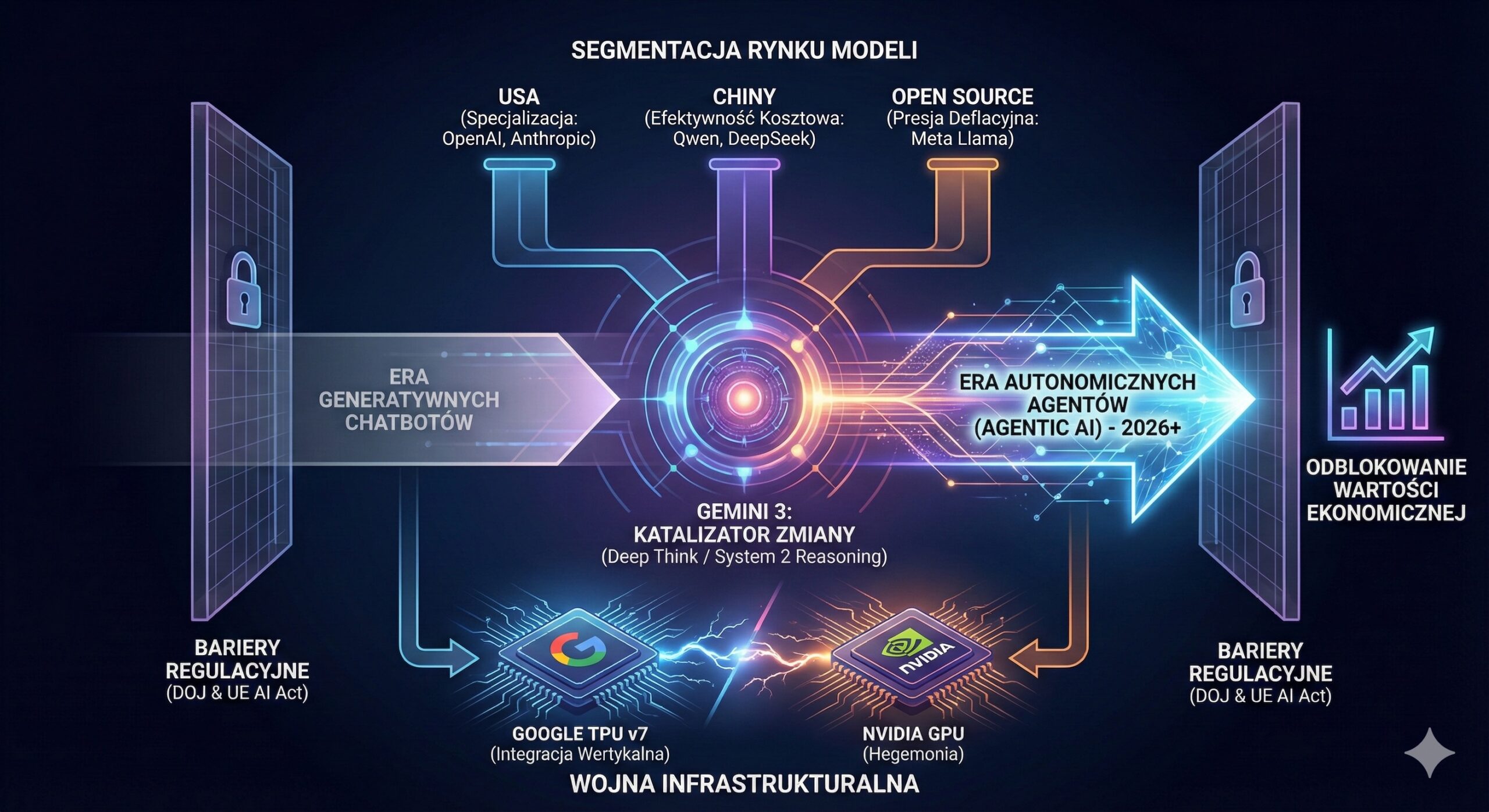

Listopad 2025 przyniósł największy wstrząs w historii sztucznej inteligencji — wejście w erę systemów wnioskujących i agentów AI. Premiera Gemini 3 nie tylko zrewidowała reguły gry technologicznej, ale też wywołała geopolityczny i infrastrukturalny tektoniczny ruch: otwartą rywalizację Google z NVIDIĄ, presję cenową ze strony modeli chińskich oraz początek rewolucji „Agentic AI”, która w 2026 roku ma odblokować wartość liczonych w bilionach dolarów. Ten raport pokazuje, dlaczego Gemini 3 jest czymś więcej niż modelem — to katalizator nowego porządku w globalnym wyścigu AI.

Listopad 2025 roku zapisze się w historii technologii jako moment definitywnego przejścia od ery generatywnych chatbotów do ery autonomicznych systemów wnioskujących (reasoning engines) oraz agentów AI. Centralnym wydarzeniem tego okresu, katalizującym szerokie zmiany rynkowe, była premiera modelu Gemini 3 przez Alphabet Inc., która nie tylko zredefiniowała standardy wydajności w benchmarkach, ale także zasygnalizowała fundamentalną zmianę w strategii dystrybucji i monetyzacji sztucznej inteligencji.1 Niniejsze opracowanie typu Deep Research, przygotowane z perspektywy analityka rynków Deep Tech, oferuje wyczerpującą analizę techniczną, ekonomiczną i geopolityczną obecnej sytuacji.

Raport identyfikuje trzy kluczowe wektory zmian. Po pierwsze, eskalację konfliktu infrastrukturalnego między Google a NVIDIA, gdzie premiera układów TPU v7 Ironwood oraz potencjalny sojusz Google z Meta Platforms zagrażają hegemonii układów GPU w centrach danych.3 Po drugie, fragmentację rynku modeli, gdzie zachodni giganci (Google, OpenAI, Anthropic) muszą mierzyć się z bezprecedensową efektywnością modeli chińskich (Alibaba Qwen 3 Max, DeepSeek V3), które osiągają parytet wydajności przy ułamku kosztów.5 Po trzecie, nadchodzącą rewolucję „Agentic AI” w 2026 roku, która według prognoz banków inwestycyjnych ma odblokować wartość ekonomiczną rzędu biliona dolarów, przekształcając AI z narzędzia konwersacyjnego w siłę roboczą.7 Analiza uwzględnia również krytyczny wpływ regulacji antymonopolowych (DOJ) i unijnych (AI Act) na architekturę dystrybucji systemów AI w najbliższych latach.9

Premiera Gemini 3, ogłoszona 18 listopada 2025 roku, stanowi kulminację dwuletniego cyklu innowacji Google, mającego na celu odzyskanie prymatu technologicznego utraconego na rzecz OpenAI. W przeciwieństwie do poprzednich iteracji, Gemini 3 nie jest pozycjonowane jedynie jako „szybszy” model językowy, lecz jako kompleksowa platforma do głębokiego wnioskowania (Deep Thinking) i operacji multimodalnych, głęboko zintegrowana z tkanką systemową ekosystemu Android.1

Sercem innowacji w Gemini 3 jest implementacja trybu „Deep Think”, który fundamentalnie zmienia sposób przetwarzania zapytań przez model. Zamiast natychmiastowej generacji tokenów, model wchodzi w fazę latentnego planowania, weryfikując hipotezy i ścieżki logiczne przed wygenerowaniem odpowiedzi końcowej.1 Jest to odpowiedź na architekturę „System 2 thinking” (myślenie wolne), która pozwala na rozwiązywanie problemów o wysokiej złożoności abstrakcyjnej.

Kluczowym, technicznym wyróżnikiem Gemini 3 jest wprowadzenie mechanizmu Thought Signatures (Sygnatury Myślowe). Są to zaszyfrowane reprezentacje wewnętrznego procesu decyzyjnego modelu, które są zwracane przez API. Wymuszenie przez Google przesyłania tych sygnatur w kolejnych turach konwersacji (turn-taking) zapewnia, że model utrzymuje spójny łańcuch wnioskowania (Chain of Thought) w długich sesjach interakcji.2 Z perspektywy inżynierii systemów agentowych, jest to przełom – pozwala bowiem na audytowalność i determinizm w działaniu autonomicznych agentów, co jest krytyczne w zastosowaniach korporacyjnych (np. analiza prawna, diagnostyka medyczna), gdzie samo „co” (wynik) jest niewystarczające bez transparentnego „dlaczego” (proces).2

Nowe API Gemini wprowadza również parametr thinking_level, dający deweloperom granularną kontrolę nad zasobami obliczeniowymi:

Analiza porównawcza wydajności Gemini 3 Pro w trybie Deep Think ujawnia znaczącą przewagę nad konkurencyjnymi modelami z końca 2025 roku, takimi jak GPT-5.1 czy Claude 4.5 Sonnet, szczególnie w domenach wymagających eksperckiej wiedzy i rozumowania wizualnego.

Tabela 1: Zestawienie wyników w kluczowych benchmarkach AI (Stan na Listopad 2025)

| Benchmark | Kategoria | Gemini 3 Pro (Deep Think) | GPT-5.1 | Claude 4.5 Sonnet | Grok 4.1 |

| Humanity’s Last Exam | Wnioskowanie ogólne (Hard) | 41.0% | 31.64% | ~25% | ~31% |

| GPQA Diamond | Wiedza naukowa (PhD level) | 93.8% | 88.1% | ~85-88% | 87.5% |

| LiveCodeBench | Programowanie (Elo Rating) | 2,439 | 2,243 | ~2,300 | 79.3% |

| ARC-AGI-2 | Abstrakcyjne rozumowanie wizualne | 31.1% | ~5% | ~5% | N/A |

| SWE-bench Verified | Inżynieria oprogramowania | 76.2% | 74.9% | 77.2% | N/A |

Źródło: Opracowanie własne na podstawie.12

Szczególną uwagę analityków zwraca wynik w teście ARC-AGI-2 (Abstraction and Reasoning Corpus). Skok z poziomu ~5% (typowe dla LLM) do 31.1% w przypadku Gemini 3 Pro sugeruje, że Google dokonało przełomu w zakresie generalizacji „zero-shot” w domenach wizualno-logicznych, co historycznie było piętą achillesową sieci neuronowych.13 Jednocześnie, w zadaniach czysto programistycznych (SWE-bench), Gemini 3 nieznacznie ustępuje modelowi Claude 4.5 Sonnet, który nadal dzierży palmę pierwszeństwa w autonomicznym kodowaniu.12

Strategia dystrybucji Gemini 3 wykracza poza tradycyjne aplikacje i API. Wraz z wersją Android 16, Google wprowadza model Gemini Nano bezpośrednio do warstwy systemowej poprzez usługę AICore.15 Jest to fundamentalna zmiana architektury mobilnej, gdzie model AI staje się komponentem systemu operacyjnego, dostępnym dla innych aplikacji poprzez API ML Kit.

Implikacje tego ruchu są wielopoziomowe:

Dodatkowo, Google wprowadza platformę „Google Antigravity”, która służy do zarządzania flotami autonomicznych agentów AI w środowisku korporacyjnym. Wskazuje to na strategiczne przesunięcie punktu ciężkości z pojedynczych interakcji użytkownika (chatbot) na masowe, zautomatyzowane procesy biznesowe działające w tle.19

Listopad 2025 roku przyniósł eskalację napięć na rynku sprzętowym AI. Relacja między Google a NVIDIA, dotychczas oparta na symbiozie, ewoluuje w kierunku otwartej rywalizacji. Google, będąc jednym z największych klientów NVIDII, jednocześnie agresywnie promuje własną infrastrukturę obliczeniową, dążąc do wertykalnej integracji całego stosu technologicznego.3

Kluczowym elementem strategii uniezależnienia się Google jest siódma generacja procesorów tensorowych – TPU v7 (kryptonim Ironwood). Analiza specyfikacji technicznej wskazuje, że Google osiągnęło punkt, w którym jego autorskie układy nie tylko dorównują, ale w specyficznych zastosowaniach przewyższają flagowe układy NVIDIA Blackwell.

Tabela 2: Analiza porównawcza infrastruktury obliczeniowej AI (2025)

| Parametr | Google TPU v7 (Ironwood) | NVIDIA Blackwell (B200) | Implikacje Strategiczne |

| Wydajność FP8 | 4.6 PetaFLOPS | 4.5 PetaFLOPS | Google osiągnęło parytet w surowej mocy obliczeniowej.3 |

| Pamięć HBM3e | 192 GB | 192 GB | Identyczna pojemność pamięci niweluje przewagę NVIDII w obsłudze dużych modeli. |

| Przepustowość Pamięci | 7.4 TB/s | 8.0 TB/s | Minimalna przewaga NVIDII, pomijalna w skali klastra. |

| Interkonekt | ICI Links (4x per chip) | NVLink (900 GB/s) | Architektura TPU jest zoptymalizowana pod gigantyczne klastry (Pody), NVIDIA pod gęstość w węźle.3 |

| Efektywność Energetyczna | ~2x wyższa wydajność/wat (vs v6) | Wysokie zużycie (wymaga 1000W+) | Krytyczna przewaga Google w kontekście limitów energetycznych data center.22 |

Google skutecznie wykorzystuje argument efektywności energetycznej. W dobie rosnących restrykcji energetycznych i konieczności budowy nowych elektrowni dla centrów danych, wyższa wydajność z wata (performance-per-watt) układów TPU staje się kluczowym atutem sprzedażowym. W testach wewnętrznych, TPU v7 wykazują 1.4x lepszy stosunek wydajności do ceny (performance per dollar) w porównaniu do GPU w specyficznych zadaniach.22

Pod koniec listopada 2025 roku rynkiem wstrząsnęły doniesienia o zaawansowanych negocjacjach między Google a Meta Platforms. Według raportów, Meta – historycznie jeden z największych nabywców GPU NVIDII – rozważa zakup procesorów TPU od Google oraz wynajem mocy obliczeniowej w Google Cloud na masową skalę, począwszy od 2027 roku.4

Implikacje tego potencjalnego sojuszu są sejsmiczne:

Mimo tych zagrożeń, NVIDIA zaraportowała w Q3 2025 rekordowe przychody na poziomie 57 miliardów dolarów (+62% r/r), a popyt na układy Blackwell jest określany jako „przekraczający skalę”.27 Wskazuje to, że w krótkim terminie rynek jest w stanie wchłonąć każdą ilość krzemu, jednak długoterminowa trajektoria wskazuje na fragmentację rynku sprzętowego.

Rynek modeli AI w IV kwartale 2025 roku uległ wyraźnej segmentacji. Podczas gdy Google stawia na wszechstronność i integrację, konkurenci obierają strategie specjalizacji.

OpenAI, odpowiadając na presję ze strony Google i Anthropic, 13 listopada 2025 roku wydało model GPT-5.1.30 Firma przyjęła strategię bifurkacji modelu na dwa warianty:

OpenAI silnie inwestuje również w narzędzia deweloperskie, takie jak GPT-5.1 Codex Max, starając się utrzymać pozycję lidera w generowaniu kodu poprzez partnerstwa ze startupami takimi jak Cursor czy Cognition.30

Anthropic kontynuuje strategię budowania modeli dla profesjonalistów. Wydany 24 listopada 2025 roku Claude 4.5 Opus jest pozycjonowany jako najinteligentniejszy model na rynku, szczególnie w zadaniach programistycznych.33

Z wynikiem 77.2% w SWE-bench Verified, Anthropic deklaruje, że „inżynieria oprogramowania została rozwiązana” (software engineering is solved).35 Model jest zdolny do autonomicznej pracy nad złożonymi zadaniami koderskimi przez 20-30 minut, samodzielnie naprawiając błędy i refaktoryzując kod.

Jednakże, wysoka cena Claude 4.5 Opus (![]() 2.00) oferuje zbliżoną wydajność (76.2% w SWE-bench) za ułamek ceny, co może ograniczyć adopcję modelu Anthropic do niszowych zastosowań wysokiego szczebla.12

2.00) oferuje zbliżoną wydajność (76.2% w SWE-bench) za ułamek ceny, co może ograniczyć adopcję modelu Anthropic do niszowych zastosowań wysokiego szczebla.12

Meta, pod wodzą Marka Zuckerberga, kontynuuje strategię „spalonej ziemi” cenowej, udostępniając potężne modele w formule source-available. Rodzina modeli Llama 4, w tym warianty Scout i Maverick, oferuje wydajność porównywalną z modelami zamkniętymi przy zerowym koszcie licencji.37

Największym zagrożeniem dla konkurencji jest nadchodzący model Llama 4 Behemoth (288B parametrów), który ma przewyższać GPT-4.5 i Claude Sonnet 3.7 w benchmarkach STEM.38 Dostępność takich modeli za darmo wywiera ogromną presję deflacyjną na ceny API Google i OpenAI, zmuszając te firmy do szukania wartości dodanej poza samym modelem (np. w ekosystemie narzędzi i integracji).

Rok 2025 ostatecznie obalił tezę o technologicznym zacofaniu Chin w dziedzinie AI. Modele z Państwa Środka nie tylko dorównują zachodnim, ale w aspektach efektywności i kosztów często je przewyższają.

Model Qwen 3 Max od Alibaba Cloud to technologiczny majstersztyk – pierwszy chiński model o skali ponad 1 biliona parametrów (MoE), trenowany na gigantycznym korpusie 36 bilionów tokenów.5 W testach takich jak LMArena czy Tau2-Bench (użycie narzędzi), Qwen 3 Max zajmuje miejsce w ścisłej czołówce światowej (Top 3), wyprzedzając standardowe wersje GPT-5.

Wariant „Thinking” modelu Qwen 3 osiąga 100% skuteczności w benchmarkach matematycznych AIME 25 i HMMT, co sugeruje, że chińscy inżynierowie opanowali techniki Reinforcement Learning (RL) niezbędne do zaawansowanego wnioskowania na poziomie równym lub wyższym niż Google DeepMind.40

Startup DeepSeek stał się symbolem chińskiej efektywności. Ich model DeepSeek V3 (oraz wariant wnioskujący R1) oferuje wydajność klasy GPT-4o przy koszcie rzędu  0.20/1M oraz darmowa dostępność Llama 4 wymuszają na gigantach obniżki. Google pozycjonuje Gemini 3 Pro (

0.20/1M oraz darmowa dostępność Llama 4 wymuszają na gigantach obniżki. Google pozycjonuje Gemini 3 Pro (![]() 15.00), ale oferujący wsparcie enterprise i bezpieczeństwo, którego brakuje modelom chińskim.6

15.00), ale oferujący wsparcie enterprise i bezpieczeństwo, którego brakuje modelom chińskim.6

Tabela 3: Porównanie ekonomiki modeli (Input/Output per 1M tokenów)

| Model | Cena Input ( | Wskaźnik SWE-bench | Stosunek Jakość/Cena |

| DeepSeek V3 | ~70% | Ekstremalnie Wysoki | |

| Llama 4 Maverick | ~72% | Bardzo Wysoki (wymaga hostingu) | |

| Gemini 3 Pro | 76.2% | Zbalansowany | |

| GPT-5.1 | 74.9% | Średni | |

| Claude 4.5 Opus | 77.2% | Niski (Premium) |

Raporty Goldman Sachs i Morgan Stanley na rok 2026 zgodnie wskazują, że rynek AI wchodzi w fazę „Agentic AI”. Oczekuje się, że wartość ekonomiczna przesunie się z prostych interfejsów czatowych na autonomiczne agenty wykonujące pracę.

Rozwój Gemini 3 napotyka na bezprecedensowe bariery prawne, które mogą zniwelować przewagi technologiczne Google.

W listopadzie 2025 roku zakończyła się faza środków zaradczych (remedies phase) w procesie US et al. v. Google. Sąd orzekł, że Google nie może zawierać umów na wyłączność dotyczących dystrybucji swoich produktów AI. Oznacza to zakaz wymuszania na producentach smartfonów (Samsung, Xiaomi) preinstalacji aplikacji Gemini jako domyślnego asystenta.9

Jest to cios w serce strategii Google, która historycznie polegała na domyślnej obecności na miliardach urządzeń. Gemini będzie teraz musiało konkurować jakością, a użytkownicy będą mieli swobodę wyboru (np. ustawienia ChatGPT jako domyślnego asystenta systemowego na Androidzie).

Dodatkowo, nakaz udostępniania danych z indeksu wyszukiwania konkurentom („Qualified Competitors”) może wzmocnić rywali takich jak Perplexity czy OpenAI (SearchGPT), niwelując „fosę” (moat) Google w postaci unikalnych danych treningowych.9

W Unii Europejskiej wdrażanie AI Act powoduje opóźnienia w dostępności najbardziej zaawansowanych funkcji. Rygorystyczne wymogi dotyczące transparentności i oceny ryzyka dla „modeli ogólnego przeznaczenia” (GPAI) sprawiają, że funkcje takie jak „Deep Think” mogą trafiać na rynek europejski z opóźnieniem. Komisja Europejska, pod presją przemysłu, rozważa pewne poluzowania (grace periods), ale niepewność regulacyjna pozostaje wysoka.10

Koniec 2025 roku to moment, w którym rynek AI dojrzewa i ulega profesjonalizacji. Google Gemini 3 jest potężną odpowiedzią technologiczną, która dzięki trybowi „Deep Think” i integracji z Androidem 16 przywraca Google do gry jako lidera innowacji. Jednakże, przewaga ta nie jest już gwarantowana przez monopol dystrybucyjny, który został skutecznie podważony przez działania DOJ.

W sferze sprzętowej, Google wyrasta na najgroźniejszego rywala NVIDII, oferując alternatywę (TPU), która jest nie tylko wydajna, ale i bardziej ekologiczna – co w obliczu kryzysu energetycznego może okazać się decydujące.

Dla decydentów biznesowych i inwestorów kluczowe wnioski są następujące:

Rynek AI przestał być wyścigiem jednej firmy. Stał się złożonym, wielobiegunowym systemem, w którym technologia, geopolityka i regulacje są nierozerwalnie splecione.

4trn valuation on reports Meta to buy Google AI chips, otwierano: listopada 26, 2025, https://www.siliconrepublic.com/business/alphabet-heads-for-4trn-valuation-on-reports-meta-to-buy-google-ai-chips

4trn valuation on reports Meta to buy Google AI chips, otwierano: listopada 26, 2025, https://www.siliconrepublic.com/business/alphabet-heads-for-4trn-valuation-on-reports-meta-to-buy-google-ai-chips